Machine Learning: Der einfache Weg zu exakten Mietpreisschätzungen

13. Mai 2021

Eine Bachelorarbeit, in Kooperation mit Wüest Partner, über die Herausforderungen und Chancen der Verwendung von „Blackbox“-Modellen in der Mietpreisschätzung.

Das Ziel der hedonischen Mietpreisschätzung ist an sich sehr simpel: Gesucht wird eine Funktion, die als Eingabewerte verschiedene Objekteigenschaften erhält und einen Preis ausspuckt, der möglichst gut die Wirklichkeit wiederspiegelt. Die klassischen Verfahren zur Mietpreisschätzung haben jedoch eine Schwachstelle. Bei ihnen werden eine Vielzahl von Annahmen getroffen und dass, obwohl zunächst einmal vollkommen unbekannt ist, wie die Schätzfunktion überhaupt aussieht. Das Problem ist schnell ersichtlich: Die Annahmen können falsch sein und es macht viel Arbeit sie alle zu überprüfen. Es wäre also erstrebenswert, für eine Schätzung möglichst wenige Annahmen treffen zu müssen.

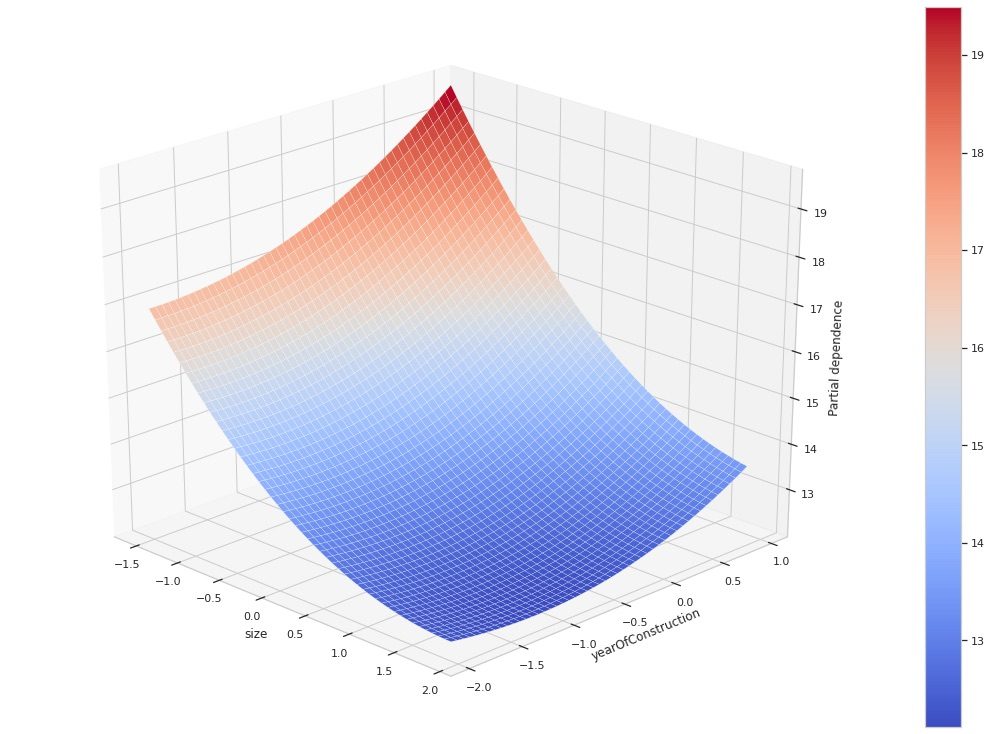

Beispiel eines Partial Dependence Plots (PDP). Der PDP zeigt den mittleren marginalen Effekt einer Veränderung von ein- oder zwei erklärenden Variablen auf die Schätzungen eines Machine-Learning-Modells. Ein PDP kann zeigen, ob die Beziehung zwischen der Zielgröße und einem Merkmal linear, monoton oder komplexer ist (Molnar, 2019). In dieser Grafik wird der mittlere Effekt einer Veränderung des Baujahrs und der Wohnungsgröße auf den Mietpreis dargestellt. Das Baujahr und der Mietpreis sind hier standardisiert.

An dieser Stelle kommt die Methode des Machine-Learnings ins Spiel. Machine Learning ist eine Sammelbezeichnung für verschiedene Algorithmen mit denen ein Computer, auf Basis von Daten, Vorhersagen treffen kann. Die Algorithmen, die sich für eine Mietpreisschätzung eigenen, können auch als nicht-lineare, nicht-parametrische Erweiterung von klassischen Regressionsmethoden verstanden werden. Ihr Vorteil gegenüber den klassischen Methoden, wie beispielsweise einer linearen Regression mit einem OLS-Schätzer, bestehen darin, dass keine Annahmen über die funktionale Form oder die zugrundeliegende Datenverteilung getroffen werden müssen. Mit Machine-Learning können nicht-lineare Beziehungen oder Wechselwirkungen der erklärenden Variablen, mehr oder weniger, automatisch erfasst werden. Daher können sie häufig exaktere Schätzungen abgeben und das auch noch mit weniger Arbeitsaufwand für den Ersteller des Schätzmodells.

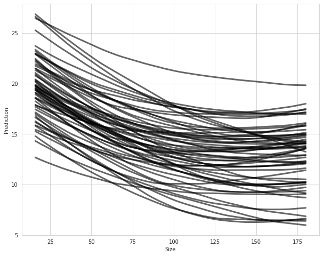

ICE-Diagramme (Individual Conditional Expectations) zeigen eine Linie pro Instanz, die anzeigt, wie sich die Vorhersage der Instanz ändert, wenn sich ein Merkmal ändert. In der Grafik sind ICE Plots von 60 zufällig gezogenen Wohnungsinseraten zu sehen, bei denen die Wohnungsgröße variiert wurde. Ziel dieser Darstellung ist es heterogene Effekte in den Schätzungen erkennen zu können und ggf. den Ursachen dafür auf den Grund zu gehen.

Doch einen Nachteil gibt es: Die Interpretierbarkeit. Die Schätzungen, die mithilfe von Machine-Learning-Modellen erstellt werden, lassen sich nur schwer nachvollziehen. Gerade das ist aber eine notwendige Voraussetzung, um der Methode trauen zu können. In der Bachelorarbeit wurde daher ein besonderer Fokus auf das sogenannte Interpretable Machine Learning gelegt; eine noch recht junge Forschungsdisziplin, die es sich zum Ziel gesetzt hat, die Schätzungen transparent zu machen. Exemplarisch wurde ein künstliches neuronales Netz, ein Paradebeispiel für ein Blackbox-Modell aus dem Bereich des Machine-Learnings, zuerst trainiert und anschließend mit Hilfe von Individual Conditional Expecatations (zu sehen in Abbildung 2), Partial Dependence Plots (zu sehen in Abbildung 1) und vielen weiteren Methoden und Darstellungsformen analysiert. Dadurch ist es möglich geworden, die gewohnte Interpretierbarkeit, à la „Wenn x sich um … verändert, dann verändert sich y um …“ , auch bei einem Machine-Learning Modellen sicherzustellen. Interpretable Machine-Learning ermöglicht so eine Verbindung und eine Ergänzung des bisher bestehenden Expertenwissens mit den Möglichkeiten von Machine-Learning.